본 캠프 2일차 날이 밝았다

어제 보다 나은 오늘! 또 다른 활기찬 하루가 시작된다

데이터 분석 종합반 - 2주차

파이썬을 본격적으로 써서 들어간다.

파이썬(Python)

파이선 개념을 다시 빠르게 살펴보자! 'rewind'

파이썬

컴퓨터에게 명령을 내리기 위해 중간에 있는 언어(번역팩 같은 것)

변수란?

데이터를 담는 컨테이너

-하나의 변수에 하나의 값만 저장한다

리스트

하나의 변수에 여러가지 값을 저장

-순서에 맞춰 값을 저장

리스트 안에 무엇이든 들어간다(숫자, 문자열, 리스트)

리스트 순서는 0부터 시작(0번째, 1번째, 2번째, ....)

[]:대괄호를 쓰는 리스트

딕셔너리

여러가지 값을 저장하건데, 각각의 이름표를 붙여 저장

리스트와 다른것은... 순서 각각에 이름표가 있다고 보면 된다

a라는 키에 : b라는 값 - key : value

{}: 중괄호를 쓰는 딕셔너리

라이브러리

다른사람이 만들어둔 코드 뭉치

우리는 이것을 이용한다

파이썬에서 쓰이는 라이브러리

pandas, matpoltlib

pandas

-범용성이 큰 엑셀이라고 보면된다(여러종류의 파일을 읽어볼 수 있다)

matpoltlib

-파이썬으로 작성된 시각화 툴

정말 단순하게 생각해보자면 데이터를 - (요리재료)

pandas, matplotlib 이 두개의 라이브러리로 - (조리도구)

데이터 결과 값을 생성하는 것 - (맛있는 음식)

본격적인 절차를 밟아보자

위 자료는 두 라이브러리를 이용해 만든 Colab이다.

이걸 이렇게 하고 설명하는것도 나쁘지 않으나, 자신이 이해한대로 나중에 와서 간편하게? 보면 좋을 정도로~

중요한 정보를 입력하는게 좋을 것 같다!

구문이 무슨 의미인지 소개!(차례대로 나열, 이 순서대로 해도 된다고 봐도 됨)

- import pandas: pandas로 부터 가져온다

- as pd: 별명 지어주기! 'pd'라는 별명을 지어준 것

- pd.read_table('(파일경로)train.csv',sep=','): 파일경로를 입력

- -참고로 파일은 사진 좌측 중단에 있는 문서에 파일을 업로드 할 수 있다.(.csv 형식)

- .head(): 파일 상단의 5개 데이터를 출력

- print(titanic.isnull().sum()): 공백 데이터 파악 -> 아래에 몇개가 비는지 알려준다

- .dropna(): 공백 데이터를 제외

- corr = titanic.corr(method='pearson'): 상관계수 구하기

- -이 구문은 데이터 분석 1주차 때 있던 correlation이랑 같은 녀석이다.(반가워요~)

- corr: 결과확인(정상적인 출력을 위해 하나 더 써 줌)

- corr = corr[corr.Survived !=1]: 상관계수 '데이터'요소가 1(최대)이 아닌 수만 불러오기

- import matplotlib.pyplot as plt: matplotlib 사용선언

- corr.plot(): 선 그래프로 차트 그리기

- corr.plot.bar(): 막대그래프로 차트 그리기

- corr['Survived(원하는 열)'].plot: 그래프로 나타낼 원하는 열을 지정

- corr = corr.drop(['PassengerId(필요없는 부분)'], axis ='rows'): 필요없는 부분을 삭제하는 구문

필연적인, 또 다른 두개의 라이브러리

numpy seaborn

numpy: 데이터연산을 빠르게 하도록 도와주는 라이브러리

-대체적으로 많은 양의 복잡한 수치를 빠르게 하도록 해준다

seaborn: matplotlib으로 부터 만들어진 데이터 시각화를 위한 라이브러리

-주로 랜덤 분포된 데이터를 시각화 할 때 이용, matplotlib보다 더 다양한 스타일이 있다

2주차를 끝마치며...

강의를 보면서 이해하려고 부단히 노력하였으나, 무조건적으로 다 외우는 것이 아니고 필요한 것을 그때 그때 씀으로서 해결.. 하므로

천천히 반복적으로 할 수 밖에 없다는 결론...!

그리고 '문제가 뭘 정의하고 가설을 어떻게 설정할 것 인지 - 데이터 분석 기본 세팅 - 데이터 분석 - 분석하고 시각화 - 최종 결론'에 이르는 걸 잘 숙지하고 머리 속에 남겨둬야 겠다.

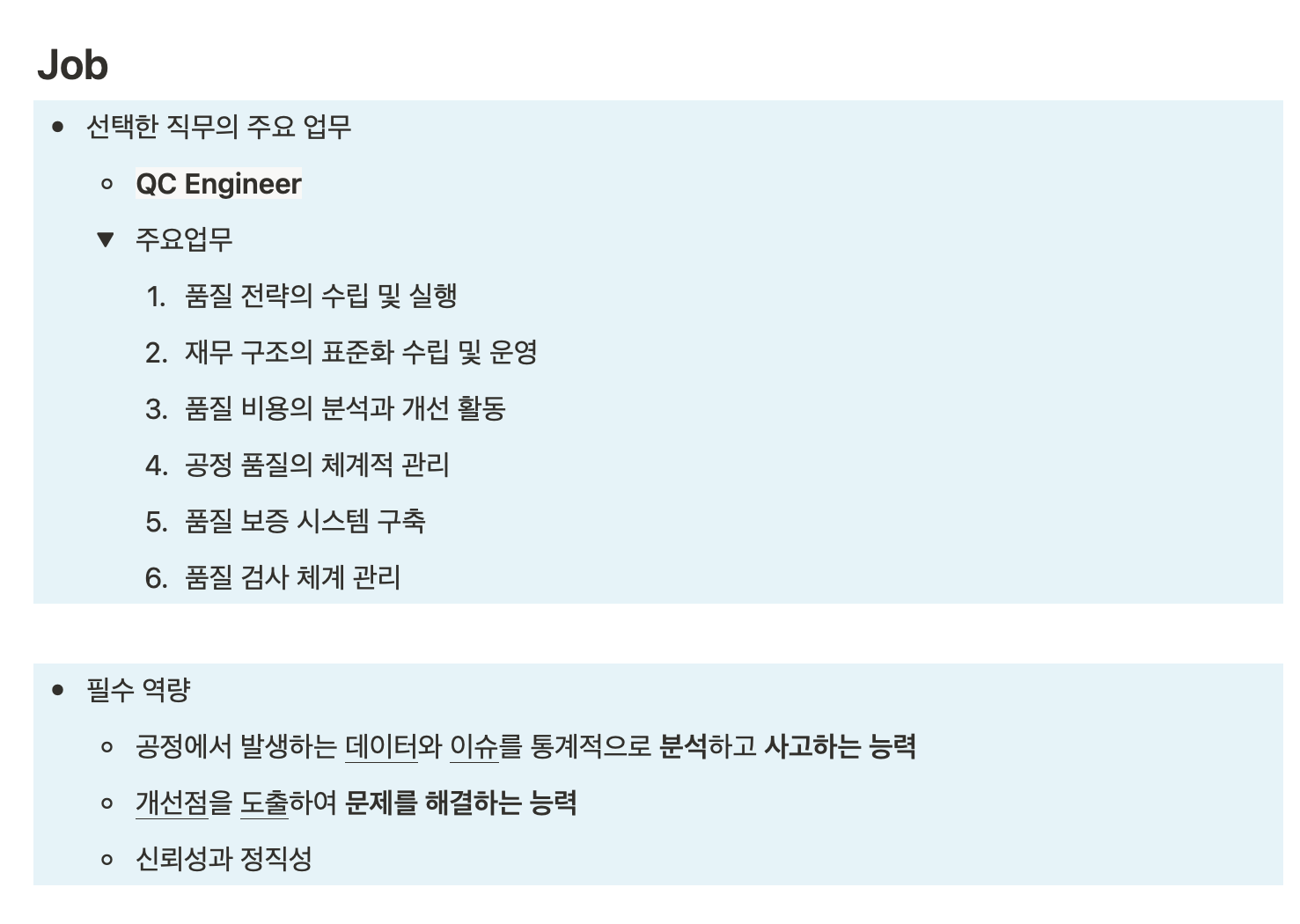

직무조사 탐색

직무조사에 들어가 볼 시간이다

나는 도메인의 대한 개념을 인터넷 홈페이지에 관한 단어밖에 몰랐는데, 여기서 말하는 도메인은 '산업군' 이라고 한다.

전자, 바이오, 농업 같은 개념 이라고 보면 이해하기 더 쉽다.(물론 예로 옆에있는걸 보여주긴 했는데, 더 확장된 개념이 있는지 궁금했음)

직무는 Data Analyst / Data Scientist / Quality Control Engineer

이렇게 3개가 있었는데, 내가 가장 흥미를 느끼는 것은 QC 부분.

고객과 기업 상호간에 필요한 물품, 그 물품이 하자가 있거나 불량이면 복합적인 문제가 있기마련... 그래서 물품이 잘 생산되는지 불량은 없는지, 잘 돌아가는지에 이 얼마나 매력적이지 않나 싶다.

그래서 몇 가지 조사를 해보았다.

개인 조사해서, 노션에 작성한게 저 내용이다.

역시 고객과 기업간의 연결다리로서 막중한 위치에 있다는 점.

앞으로 목표로 삼고 저 큰 산을 넘기위해 더 노력해한다는 점. 잊지 않겠다...

최종적으로 마치며...

내일은 내일의 시간이 기다리고 있고, 데이터 분석 종합반 3주차를 끝내고... 이해를 한번 더하려 2주차를 복습하겠다

'[내일배움캠프]' 카테고리의 다른 글

| [QA/QC_2기]온보딩주차 Final: 본캠프 Day 6_2025.05.19. (1) | 2025.05.19 |

|---|---|

| [QA/QC_2기]직무조사 마무리, 한 주의 끝: 본 캠프 Day 5_2025. 05. 16. (1) | 2025.05.16 |

| [QA/QC_2기]반복 학습: 본 캠프 Day 4_2025.05.15. (3) | 2025.05.15 |

| [QA/QC_2기]데이터 분석 더 알아가기: 본 캠프 Day 3_2025. 05. 14. (1) | 2025.05.14 |

| [QA/QC_2기] 온보딩(Onboarding) 본 캠프 Day 1_2025. 05. 12. (1) | 2025.05.12 |